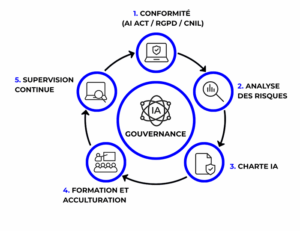

IA Responsable : le rôle clé de la gouvernance en 5 étapes

Publié le : 4 novembre 2025

Pourquoi structurer la gouvernance de l’IA maintenant ?

L’intelligence artificielle est aujourd’hui une technologie à la fois puissante et omniprésente. Elle transforme en profondeur la manière dont les entreprises décident, produisent, recrutent et interagissent avec leurs clients.

Ses bénéfices sont indéniables — automatisation, personnalisation, prédiction, optimisation — mais cette puissance, si elle n’est pas encadrée, peut rapidement devenir une source de déséquilibre et de perte de confiance.

Biais algorithmiques, opacité des décisions, fuite de données, dépendance technologique : les risques sont nombreux et bien réels.

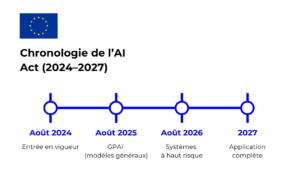

Dans un contexte où l’AI Act européen entrera progressivement en vigueur entre 2025 et 2027 , et où la CNIL renforce ses lignes directrices sur les systèmes algorithmiques (fiches pratiques 2024–2025), les entreprises doivent passer d’une approche exploratoire à une approche structurée, gouvernée et mesurable.

La gouvernance de l’IA s’impose ainsi comme un levier de compétitivité, de conformité et de responsabilité sociale.

L’enjeu n’est plus de savoir si l’on utilise l’IA, mais comment on la déploie, la supervise et la fait évoluer dans le temps.

1. Cadre réglementaire et législatif : aligner droit, technique et gouvernance

L’AI Act instaure une approche graduée : plus le risque est élevé, plus les exigences en matière de documentation, supervision et robustesse sont strictes.

En parallèle, le RGPD continue de garantir la protection des données utilisées pour entraîner ou exploiter les systèmes d’IA.

Échéancier AI Act (points clés) :

- Août 2024 : entrée en vigueur du règlement (publication Juillet 2024).

- Août 2025 : premières obligations pour les modèles GPAI (généralistes).

- Août 2026 : application générale des obligations, dont les systèmes à haut risque.

- 2027 : régime pleinement effectif (mise en place complète des mécanismes).

Réfs : Commission européenne, note de synthèse du Parlement européen.

Concrètement :

- Les IA à haut risque (recrutement, scoring, santé, finance) doivent être documentées, auditées et surveillées.

- Les systèmes génératifs doivent informer clairement l’utilisateur et expliciter leur logique de génération.

- Les DPO et RSSI doivent créer un référentiel commun IA + RGPD pour assurer la cohérence entre conformité, sécurité et innovation.

Le droit à ne pas faire l’objet d’une décision purement automatisée (article 22 du RGPD) reste une boussole essentielle : garantir une supervision humaine effective et des voies de recours.

Réf : Texte RGPD – art. 22.

Les entreprises pionnières associent désormais ces volets à une gouvernance élargie : comité éthique, revue trimestrielle des cas d’usage, indicateurs de performance responsable. C’est l’alignement des trois dimensions : juridique, technique et humaine – gage d’une IA robuste, de confiance.

🔗 Texte intégral du Règlement RGPD (UE 2016/679)

2. Analyse des risques : identifier et classer les risques IA

Avant de déployer une IA, il faut cartographier les usages et évaluer les impacts. Chaque système doit être classé selon son niveau de risque — inacceptable, élevé, modéré ou minimal — en cohérence avec l’AI Act.

Quelques questions clés pour guider cette analyse :

- Cette IA influence-t-elle une décision concernant une personne ?

- Les données utilisées sont-elles sensibles ou personnelles ?

- Y a-t-il un risque de biais, de discrimination ou de manipulation ?

Une telle cartographie permet de prioriser les projets nécessitant un contrôle renforcé.

Les AIPD (analyses d’impact) deviennent alors des outils d’aide à la décision, et non contraintes administratives.

Mettre en place un registre des usages IA, mis à jour régulièrement, constitue une base solide pour suivre les évolutions, identifier les dérives et établir un lien clair entre la stratégie d’entreprise et la conformité réglementaire.

3. Instaurer une charte IA pragmatique

La charte IA est la boussole interne de la gouvernance. Elle ne doit pas être une simple déclaration d’intention, mais un cadre opérationnel clair et partagé entre managers, collaborateurs et prestataires.

Elle précise :

- Des exemples concrets d’usages autorisés et non autorisés.

- Les consignes de sécurité sur les données (aucune donnée sensible dans les outils externes sans validation DSI/DPO).

- Le rappel du rôle central de la supervision humaine.

- Des procédures d’alerte en cas de dérive ou d’erreur IA.

Pour renforcer son adoption, la charte peut être accompagnée d’un kit de sensibilisation : vidéos internes, fiches réflexes, ateliers de décryptage d’usages réels.

Son objectif n’est pas de brider, mais de rendre chacun responsable de ses interactions avec l’IA.

Les bonnes pratiques : une révision semestrielle, un QR code d’accès direct sur l’intranet et un engagement signé à l’onboarding.

Une charte comprise et appliquée, c’est une gouvernance partagée.

🔗 Recommandations OCDE sur la gouvernance IA

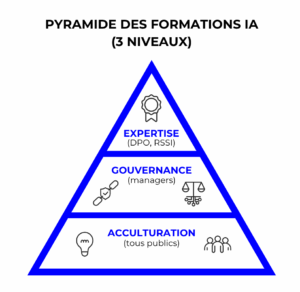

4. Former et acculturer : la compétence comme colonne vertébrale

Aucune gouvernance d’IA ne tient sans formation ni montée en compétences.

Former, ce n’est pas seulement apprendre à utiliser des outils : c’est comprendre les mécanismes, les risques et les responsabilités.

Niveau 1 : tous collaborateurs : acculturation à l’IA

Créer une culture commune autour de l’IA, de la donnée et de la cybersécurité en déployant des modules de formation courts, (e-learning, fiches, vidéos) adaptés pour tous, pour sensibiliser aux bonnes pratiques.

Par exemple, l’e-learning de Docaposte Institute sur la découverte de l’IA générative, permet de comprendre les fondamentaux : comment fonctionne une IA, quels sont ses risques, et comment protéger ses données.

Ces formations favorisent la confiance et développent une posture éthique dès les usages du quotidien : rédaction, recherche d’informations, traitement de données ou échanges clients.

Niveau 2 : Managers et fonctions support – Gouverner et arbitrer

Les décideurs (RH, DSI, juristes, DPO, chefs de projet) doivent savoir évaluer un cas d’usage, arbitrer les risques et piloter les équipes.

Les formations telles que RGPD : les fondamentaux, Éthique du numérique, ou Accompagner ses équipes dans l’intégration de l’IA renforcent cette posture.

Elles abordent les grands axes : gouvernance réglementaire (AI Act, CNIL), gestion du risque et de la conformité, pilotage d’équipes dans un environnement numérique en mutation.

Ces parcours développent aussi des compétences de leadership numérique, essentielles pour instaurer la confiance et accompagner le changement.

Niveau 3 : Experts techniques – Maîtriser et sécuriser

Les data scientists et développeurs doivent pouvoir concevoir, documenter et auditer des systèmes d’IA responsables.

Les formations comme IA générative pour les filières techniques ou la certification Compétences du DPO (CNIL) approfondissent la robustesse, l’explicabilité et la conformité des modèles.

Elles couvrent la conception éthique, la documentation technique, la cybersécurité, le MLOps responsable et la conformité RGPD/AI Act.

Ce sont des leviers essentiels pour créer des modèles auditables, traçables et alignés avec les exigences européennes.

🔗 Catalogue complet Docaposte Institute – IA & Gouvernance numérique

Quels sont les indicateurs à suivre, pour mesurer la maturité IA ?

- % de collaborateurs formés à la culture IA.

- % de projets IA validés avant déploiement.

- % d’incidents IA détectés et corrigés par les utilisateurs eux‑mêmes.

- Niveau de conformité au RGPD et à l’AI Act sur le périmètre projet.

Selon le baromètre France Num 2025, 20 % ont suivi une formation numérique, mais 55 % citent le manque de temps comme frein principal. Ce différentiel justifie un plan de formation échelonné et mesurable.

5. Mettre en place une supervision continue

L’IA doit être suivie dans le temps. Le comité IA devient alors une pièce maîtresse : il centralise la veille réglementaire et technologique, suit les indicateurs de formation, conformité et biais, valide les nouveaux cas d’usage et coordonne les actions correctives avec la DSI, le DPO et la DRH.

Certaines entreprises vont plus loin : elles associent leur comité IA à des panels de collaborateurs pour tester les nouveaux outils avant déploiement. D’autres publient un rapport annuel de gouvernance IA, inspiré des bilans RSE, pour rendre compte de leur maturité et de leur transparence.

Référentiels utiles :

- ISO/IEC 42001:2023 – AI Management System : cadre de management applicatif pour la gouvernance, l’amélioration continue et la maîtrise des risques IA (ISO).

- Principes OCDE de l’IA : repères de haut niveau sur une IA digne de confiance (OCDE).

Cette supervision continue transforme la gouvernance IA en levier d’amélioration et d’innovation durable.

🔗 Norme ISO/IEC 42001:2023 – Systèmes de management de l’IA

Gouverner l’IA, c’est construire la confiance

La gouvernance de l’IA ne se décrète pas : elle se construit dans le temps, par l’action, la pédagogie et la régularité.

Former, expliquer, ajuster : trois verbes pour une IA responsable et utile.

Les entreprises qui feront de la compétence et de la transparence les piliers de leur gouvernance seront celles qui tireront le meilleur de l’intelligence artificielle — sans en subir les dérives.

💡 Docaposte Institute accompagne les organisations dans la mise en place de programmes de formation en lien avec une gouvernance IA responsable, pour allier innovation, conformité et confiance.